Catégories transversales

Ces projets forment un corpus expérimental organisé autour de quatre axes de recherche transversaux :

Interfaces invisibles

– Quand la technique disparaît pour mieux orienter nos comportements.

– Design de la fluidité, effacement de la médiation, illusion de neutralité.Objets à affect

– Machines empathiques, émotionnelles ou moralisatrices.

– L’interface comme partenaire sensible, entre soin et manipulation.Automatisation du pouvoir

– Décision, délégation, autorité : où s’arrête la responsabilité humaine ?

– L’IA comme agent moral et politique dans les micro-espaces du quotidien.Animisme industriel

– Les objets agissent, répondent, résistent : nouvelles cosmologies du technique.

– Comprendre la machine comme cohabitant plutôt que comme simple outil.

À travers ces projets, la Chaire Managia développe une anthropologie du futur technique.

Elle interroge les formes émergentes d’intelligence incarnée, de dépendance assistée et de cohabitation algorithmique — pour mieux comprendre comment, demain, nos objets penseront avec nous, pour nous… ou à notre place.

-

![]()

STRATOSPHÈRE

STRATOSPHÈRE — La cohabitation augmentée

Un système d’assistance intelligente accompagne l’humain dans ses déplacements verticaux et ses micro-mobilités.

Enjeu : la cohabitation entre autonomie technique et autonomie humaine.

Question : jusqu’où déléguer sans perdre la capacité de décider ?

Une IA sensible, performante mais socialement située.

-

![]()

prompthèque

PROMPTHEQUE — Le miroir de pratique

Une bibliothèque de prompts virtuelle doublée d’un journal d’usage : chaque requête est horodatée, émotionnée, commentée, associée à une raison de choix ou de rejet, puis restituée dans une data-viz hebdomadaire qui révèle pics d’usage et hyper-prompting.

Enjeu : rendre visibles les mécanismes tacites de nos pratiques numériques pour passer d’un pouvoir implicite à un partage maîtrisé.

Question : comment transformer l’intuition en décision justifiée sans perdre la spontanéité de l’usage ?

Une IA qui documente, éclaire et versionne les gestes plutôt que de les remplacer.

-

![]()

kickback

KICKBACK — Les objets à réaction

Une chaise équipée de capteurs réagit physiquement à l’attitude de son utilisateur.

Enjeu : le feedback comme langage et l’agentivité des objets.

Question : à quel moment l’objet cesse-t-il d’être support pour devenir acteur ?

Un artefact qui incarne la tension entre confort et domination des objets connectés.

-

![]()

aristote

ARISTOTE — L’interprétation en direct

Un agent conversationnel doté d’un panneau d’interprétation : il dévoile en temps réel ses étapes de raisonnement — sources, hypothèses, code — et génère une trace exportable (journal ou vidéo) pour analyse.

Enjeu : réduire l’opacité des modèles et casser la confiance naïve en rendant visible la mécanique de l’inférence.

Question : comment apprendre à piloter une IA plutôt que la subir, et distinguer certitude affichée et véritable preuve ?

Une IA transparente, inspectable, dont le fil de pensée devient un support de critique et de formation.

-

![]()

ai-secure

AI SECURE — La surveillance invisible

Un bracelet haptique qui s’allume et vibre dès qu’un diagnostic automatisé ou une reconnaissance faciale est détecté à proximité, tout en stockant localement les volontés anticipées de l’utilisateur pour constituer une preuve en cas d’erreur.

Enjeu : rendre visibles les traitements sensibles et rééquilibrer l’asymétrie d’information entre citoyens et systèmes algorithmiques.

Question : comment redonner à l’individu un droit d’opposition in situ au moment où la décision bascule vers la machine ?

Un objet d’alerte qui matérialise la présence du calcul et sert de support probatoire.

-

![]()

Aria

ARIA — La vigilance affective

Un dispositif de régulation émotionnelle pour enfants, entre compagnon et surveillance.

Enjeu : l’éducation émotionnelle à l’ère de l’assistance automatisée.

Question : peut-on déléguer la régulation du lien affectif à une machine ?

Une interface éducative ambivalente : entre soin, contrôle et normalisation.

-

![]()

lumia

LUMIA — La lumière comme indicateur

Une lampe de bureau qui traduit, en ambiance lumineuse, le temps économisé grâce à l’IA : du cyan apaisant au rouge d’alerte, avec une luminosité qui diminue automatiquement au-delà d’un seuil critique.

Enjeu : rendre perceptible le moment où l’assistance commence à remplacer l’apprentissage plutôt qu’à le soutenir.

Question : comment instaurer une sobriété d’usage sans contrainte sociale, simplement par un signal ambiant ?

Un dispositif lumineux qui cadence l’effort, matérialise le just-in-prompt et réinstalle des anti-rythmes dans le travail quotidien.

-

![]()

mood shift

MOOD_SHIFT — L’émotion comme interface

Un miroir intelligent module la représentation de soi selon l’humeur de l’utilisateur.

Enjeu : la quantification et la marchandisation des émotions.

Question : comment l’IA influence-t-elle notre perception de nous-mêmes ?Un objet miroir qui transforme la réflexivité en donnée comportementale.

-

![]()

sous-condition

SOUS-CONDITIONS — Les préférences mises à nu

Un jeu de cartes « Tu préfères… ? » qui expose nos conditions réelles de recours à l’IAG. Chaque carte propose un dilemme situé — recréer un souvenir via une IA ou le reconstruire à partir d’un récit ? découvrir un artiste par soi-même ou via les suggestions algorithmiques ? — afin de faire expliciter les raisons plutôt que de compter des points.

Enjeu : révéler les routines invisibles qui nous font basculer automatiquement vers l’IA et questionner la frontière entre création personnelle et assistance.

Question : comment transformer une préférence spontanée en position argumentée et partageable, sans culpabilisation ni jugement ?

Un rituel ludique pour instaurer un lexique commun, éclairer les habitudes d’usage et déclencher un sevrage doux de l’autopilote.

-

![]()

La centrale

LA CENTRALE — L’IA du contrôle

Projet prospectif sur les véhicules autonomes de luxe.

Enjeu : qui décide de l’accélération, du freinage, du risque ?

Question : où se situe la responsabilité lorsque la machine maîtrise le mouvement ?

Une intelligence performative et invisible qui étend le champ du contrôle.

-

![]()

nora

NORA — Le compagnon révélateur d’IA

Un widget-compagnon relié à l’ordinateur de travail qui trace l’empreinte de l’IA tout au long d’un projet : pastille d’alerte discrète, visualisation du chemin d’influence et propositions d’alternatives non-IA lorsque nécessaire.

Enjeu : dévoiler la chaîne d’influence invisible et dépasser l’illusion d’innocuité (« si c’est en amont, ça ne compte pas »).

Question : comment identifier, équilibrer et assumer la part réelle de l’IA dans la conception, sans culpabiliser l’utilisateur ?

Un outil réflexif qui révèle les dérives subtiles, suggère des contre-gestes analogiques et installe une hygiène de provenance dans le processus de design.

-

![]()

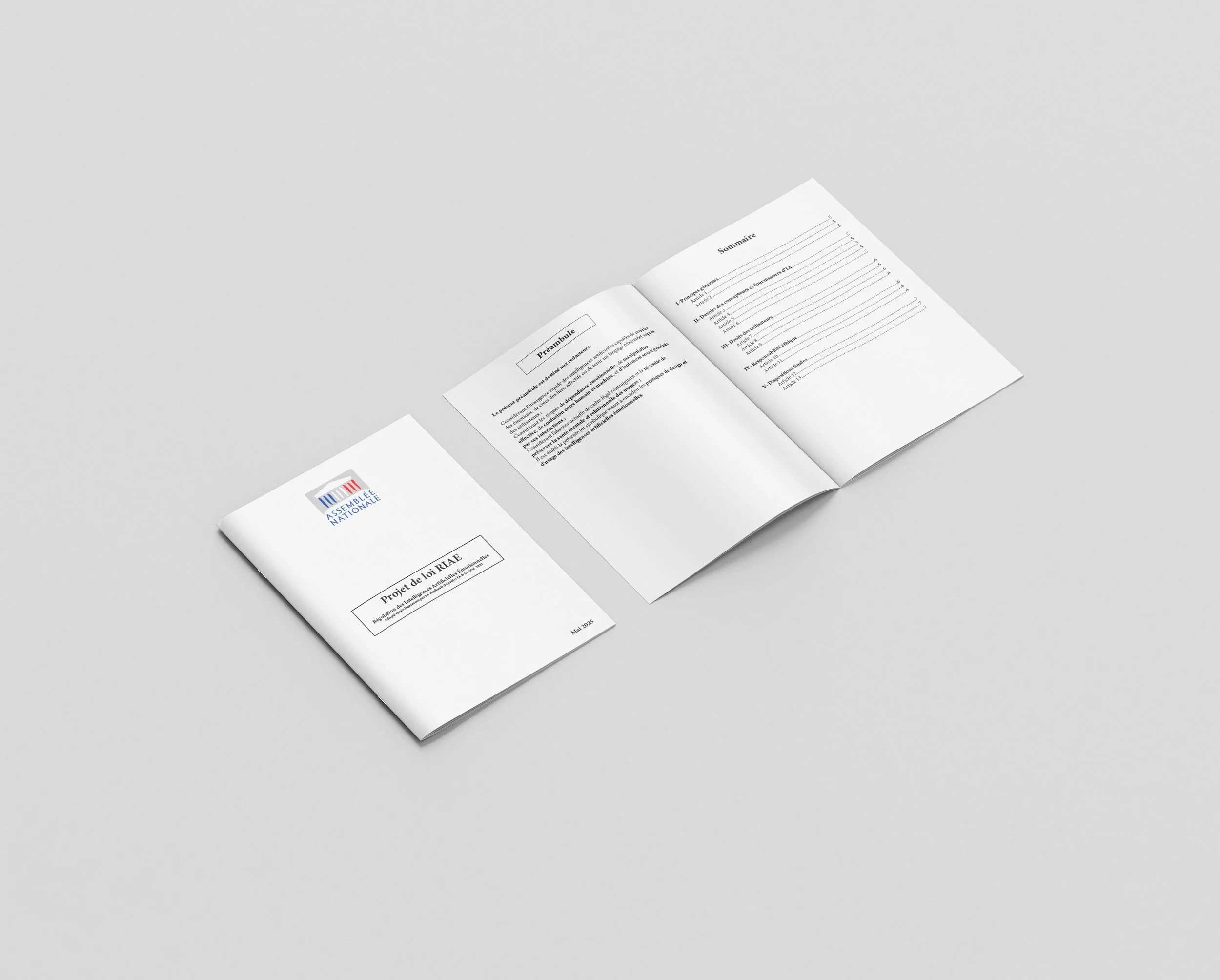

loi riae

Loi RIAE — Le cadre des affects simulés

Un « code civil » imprimé sur papier bible où chaque article est associé à un cas d’école illustré, définissant quand, comment et sous quelles conditions une émotion simulée — assistant empathique, voice clone, tonalité chaleureuse — peut être considérée comme recevable.

Enjeu : éviter l’ajout automatique de “chaleur” ou d’empathie artificielle sans justification, en posant un cadre clair aux affects générés par les interfaces.

Question : comment décider, de façon argumentée et transparente, quand une émotion simulée est légitime dans une interaction homme–machine ?

Un outil légistique léger qui structure l’éthos des interfaces et encadre la conception de fonctions empathiques.

-

![]()

boîte à waf

BOITE A WAF — Le sursaut d’usage

Un plug-in qui intercepte chaque appel API vers un modèle génératif : une petite mascotte apparaît, compte les usages et propose une alternative hors-ligne avant de laisser continuer.

Enjeu : freiner l’usage réflexe du just-in-prompt et limiter la dépendance procédurale liée aux automatismes.

Question : comment instaurer un sevrage doux qui invite à réfléchir sans culpabiliser ni bloquer la créativité ?

Une présence légère qui introduit un micro-temps d’attention, propose des contre-gestes analogiques et rend visibles les routines d’appel à l’IA.

-

![]()

équitech

EQUITECH — L’audience du modèle

Une installation mêlant logiciel et architecture qui met « l’IA à la barre » : elle affiche en temps réel des preuves statistiques de discrimination grâce à un module d’audit et instaure un rituel contradictoire au sein de l’équipe.

Enjeu : relocaliser l’imputation en cessant de dire « le modèle a sorti ça » pour interroger qui corrige, pourquoi et sur quelles variables.

Question : comment instaurer un temps moral non compressible dans un sprint de production et produire une preuve de correction opposable ?

Une scène d’audience qui structure la critique, éclaire les biais et oblige à un verdict correctif (re-générations, contre-prompts, retouches).